4/1から新卒で入社した高津です。

4/1から新卒で入社した高津です。

RDS で、大量のIO を伴う処理を行うと、処理途中で性能が大きく劣化することがあります。 不要になった大量の過去データをバッチで削除する時によく発生します。 これは、ストレージへの IO を規定量より高い頻度で行った時に減少するクレジットがあり、それが 0 になった時、パフォーマンスに制限がかかってしまうためです。

こんにちは、品質管理係の渡辺です。

品質管理係のお仕事の中に『システム動作の検証』というお仕事があるので、少しお話をしようと思います。

当社 TORICO ではモバイルアプリ開発のフレームワークに Flutter を採用し、ウェブのフロントエンドのフレームワークとしては Nuxt を採用しています。 普段 Nuxt で開発している方が Flutter での開発を始める際、Flutter での状態管理フレームワークとして、riverpod + hooks_riverpod を使う場合、基本的な使い方を Vuex と比較すると早く理解できますので、説明します。

この記事は、株式会社TORICO Advent Calendar 2021 12/21 の記事です。 他社の方と話をした際、お子さんがアプリケーションエンジニアに興味があるという話を聞いたので、これからアプリケーションエンジニアになる人に向けての記事を書こうと思いました。

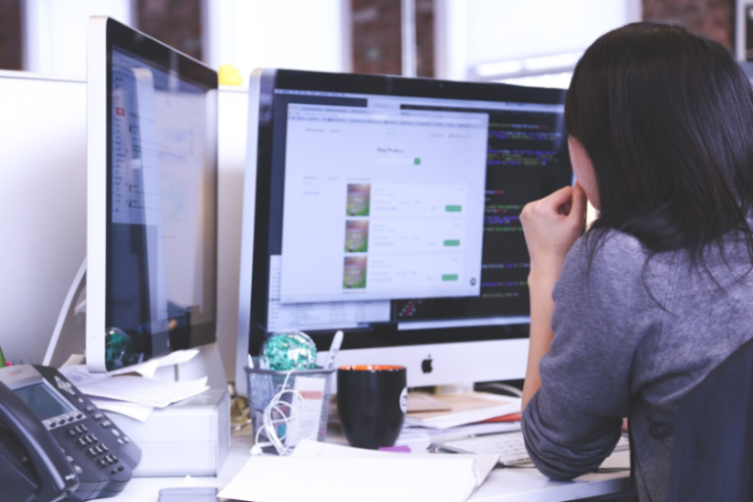

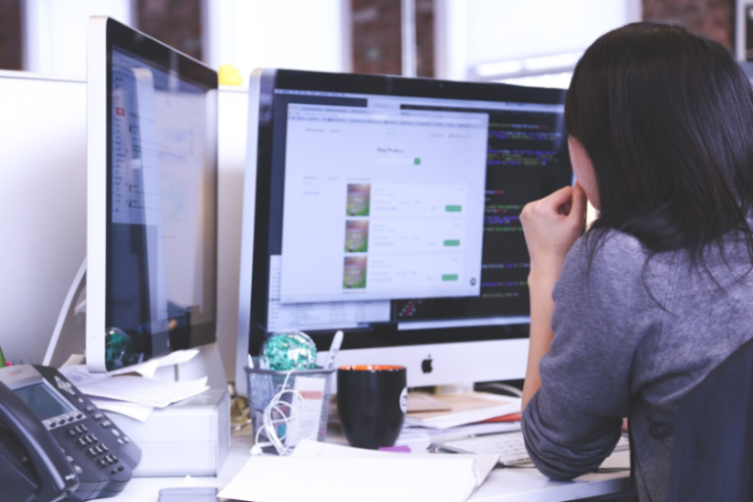

「新入社員が入社後数ヶ月でコミックリーダーアプリのレビュースコアを 1.4 → 4.7 に改善した話」として、新入社員の Flutter エンジニアが入社後はじめに取り組んだ開発課題の流れや、その時心に残ったことなどを、弊社のサービスや開発チームに興味をもって下さる方に向けて紹介します。

主に私の会社 TORICO の若いアプリケーションエンジニア(プログラマ)や、部下・チームを持ったエンジニアに読んでほしい本をリストアップしました。リーダブルコード、プリンシプルオブプログラミング、UNIXという考え方、達人プログラマー

TORICOでは、開発者のエディタは JetBrains のもの (PyCharm, WebStorm, PHPStorm 等) を使うことにしています。今回、最初に必ず覚えたいショートカット・機能を紹介します。

ディレクションチームと開発チームで「完了」状態のイメージを揃えておかないと、この課題だけではなく、その次の課題の進捗にも遅延が発生します。お互いに、「完了」とは何かをより具体的にイメージしておくことが、開発をスムーズに進めることに繋がります。

新卒エンジニアとして半年間働いてきて、現場でさまざまなことを勉強させていただきました。その中でも、もっと早く知っておきたかった便利なツール、Python の書き方など、幅広いあれこれを記事にしたいなと思います。

就社してからは初めてのブログ投稿となります。

今回の記事は新型コロナウイルスの影響で普段リモート開発をしていて浮き彫りになった問題点の1つとして「開発側と運用側でコミュニケーションが難しい時がある」といったものがありましたので、その原因として考えられる「IT専門用語が難しくしている」に焦点を当てて、業務中に発生した知ってもらえたら嬉しい用語を(個人的頻出度で)紹介していきます。(かなり噛み砕いていますので厳密で完璧にあっているものではないものもあります)

<p><img alt="" src="https://d1qjlssvz4u32r.cloudfront.net/media/uploads/site-6/head/book-520610_640.jpg" width="800" /></p>

今年の春に入社しました、情報システム部の清瀬です。

2021年春に入社しました、情報システム部の清瀬です。

株式会社TORICO情報システム部の四斗邊です。 PMS、ISMS関連の後編です。 今回はPマーク認証、ISO27001認証を取得する際のコンサルを選ぶポイントについて話したいと思います。

はじめまして株式会社TORICO情報システム部の四斗邊です。 いきなりですが、PMSとISMSについてお話したいと思います。 なぜこの話をしようと思ったかといいますと、株式会社TORICOでは、2021年1月にPマーク認証を取得、2021年2月にISMS認証(別名ISO/IEC 27001)を取得したからです!

本には商品判別のためのバーコードがついています。いわゆるISBNコード(JANコード)です。ECショップでは本を取り扱うために本の書誌を記録するテーブルを作成しますが、その際にint型でいいだろう? ユニーク制約でいいか?とおもってはいけないません。

海外回線からリクエストされた時に応答を変えるようなサービスで、実際の海外からアクセスした時のレスポンスを日本国内のPCから試したい場合は、SOCKS プロキシを使うと便利です。 実際に起動した、自分のコントロールしているサーバを使います。怪しげな VPN サービスを使わないため安全です。